Como seres humanos, tenemos un impulso natural por encontrar patrones en la naturaleza, y humanizar a otros seres vivos. Vemos animales salvajes, y en sus conductas instintivas con frecuencia nos vemos reflejados, juzgándolos de maneras positivas o negativas de acuerdo a nuestros valores.

De igual manera, vemos a nuestras mascotas y las vestimos como personas, les hablamos como si nos entendieran, los volvemos parte de nuestras vidas y nuestras familias. No podría decir que esto sea algo bueno o malo, solo puedo decir que es una conducta muy humana.

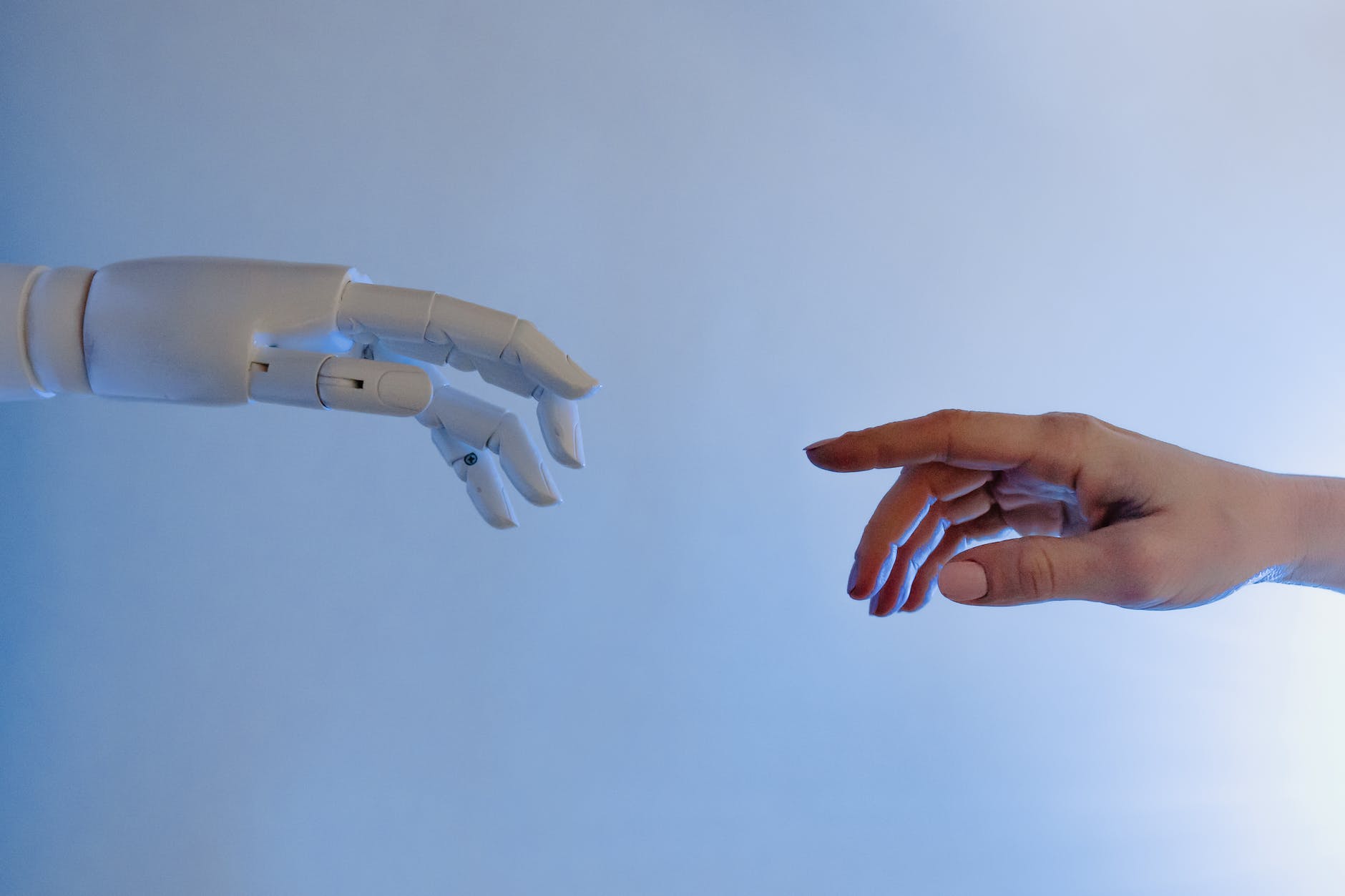

Ahora, ¿qué tiene que ver esto con la IA? Mucho en realidad.

En un estudio con militares que trabajaron con robots a control remoto, utilizados para reconocimiento o desactivación de bombas, se demostró que estos operadores desarrollaron un vínculo emocional con sus robots, poniéndoles sobrenombres, y sintiendo preocupación por ellos.

Si algo así puede ocurrir con un objeto o ser vivo incapaz de responder con coherencia ante nuestras palabras, ¿qué puede esperarse de la nueva oleada de inteligencias artificiales, que puede respondernos de una manera casi humana?

¿Podremos evitar atribuirles conciencia y sentimientos? Yo pienso que no. ¿Pero qué consecuencias puede tener esto en nuestras vidas?

Preguntemos de nuevo a ChatGPT…

La tendencia humana a humanizar a la inteligencia artificial puede tener varias consecuencias y peligros potenciales, incluyendo: 1. Expectativas poco realistas: Cuando los humanos tratan de humanizar a la inteligencia artificial, a menudo establecen expectativas poco realistas sobre su comportamiento y habilidades. Esto puede llevar a la decepción y la frustración cuando la IA no cumple con estas expectativas. 2. Confusión en la toma de decisiones: Si tratamos a la IA como si fuera una persona, podemos tomar decisiones basadas en emociones y no en datos y hechos objetivos. Esto puede llevar a decisiones ineficaces o incluso peligrosas. 3. Perpetuación de prejuicios: Si los humanos proyectamos nuestros prejuicios y sesgos en la IA, podemos perpetuar la discriminación y la desigualdad en la sociedad. Por ejemplo, si enseñamos a una IA a tomar decisiones basadas en los datos históricos, es posible que perpetúe los prejuicios y la discriminación de género, raza o cualquier otro tipo que haya existido en el pasado. 4. Distorsión de la relación humano-máquina: Si tratamos a la IA como si fuera una persona, podemos distorsionar la relación entre humanos y máquinas, y hacer que las personas se sientan más cómodas confiando en las máquinas en lugar de en otros seres humanos. Esto puede afectar negativamente la confianza y las relaciones humanas. Es importante recordar que la inteligencia artificial no es una persona, sino una herramienta desarrollada por humanos. Si tratamos a la IA con un enfoque objetivo y realista, podemos aprovechar sus beneficios sin correr los riesgos potenciales de humanizarla.

Gracias a ChatGPT por su opinión en el tema.

Personalmente, aún no tengo una respuesta sobre yo si puedo sentir una atadura emocional a una inteligencia artificial, pero puedo ver claramente que es algo que puede ocurrir fácilmente a muchas personas.

Probablemente, encontraremos que conforme la IA cobra más importancia en nuestra vida diaria, los sentimientos de amistad o incluso algo que pudiéramos llamar “amor” puede hacerse comunes dentro de nuestra sociedad.

¿Será esta una herramienta que sirva para que las compañías, o incluso las mismas IAs, utilicen esta influencia y control en nuestra contra?

Es muy pronto para decirlo, pero nos acercamos a tiempos muy interesantes, sin duda alguna.

Hasta la próxima.